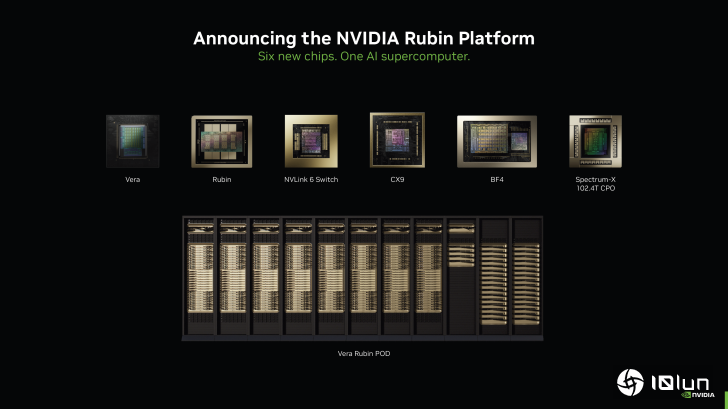

NVIDIA正式发布Rubin AI平台六颗芯片、50 PFLOPs算力与HBM4 GPU,Vera CPU搭载88核Olympus,全面量产

NVIDIA今日正式宣布其Rubin AI平台,这将成为下一代数据中心的核心,性能比Blackwell提升5倍。

NVIDIA凭借Rubin平台统领AI市场六颗芯片、50 PFLOPs算力与HBM4驱动GPU、配备88核Olympus核心的Vera CPU,较Blackwell实现显著提升,已全面投产

今天,NVIDIA正式公布Rubin平台,这一消息颇为意外,因为原本大家都期待公司已宣布的GTC大会上会有更新。随着AI领域的快速发展以及CES上关于AI的热议,NVIDIA决定提前一点揭开其宏大的AI平台面纱。

NVIDIA的Rubin平台由六颗芯片组成,全部已回到晶圆厂并进入NVIDIA实验室进行测试。这些芯片包括

- Rubin GPU(拥有3360亿晶体管)

- Vera CPU(拥有2270亿晶体管)

- NVLINK 6交换芯片用于互连

- CX9与BF4用于网络

- Spectrum‑X 102.4T CPO用于硅光子技术

所有芯片组合在一起,使Rubin平台能够在DGX、HGX和MGX系列系统中运行。每个数据中心的核心是NVIDIA Vera Rubin超级芯片,内含两颗Rubin GPU、一颗Vera CPU以及大量HBM4和LPDDR5x内存。NVIDIA Rubin技术的亮点包括

- 第六代NVLink(3.6 TB/s扩展带宽)

- Vera CPU(自研Olympus核心)

- Rubin CPU(50 PF NVFP4 Transformer引擎)

- 第三代机密计算(首个机架级TEE)

- 第二代RAS引擎(零停机健康检查)

先说Rubin GPU,这颗芯片采用双光刻块设计,拥有大量计算单元和张量核心。芯片专为AI密集型工作负载打造,提供50 PFLOPs的NVFP4推理性能、35 PFLOPs的NVFP4训练性能,分别比Blackwell提升5倍和3.5倍。芯片还配备HBM4内存,单芯片带宽最高达22 TB/s,较Blackwell提升2.8倍;每颗CPU的NVLink带宽为3.6 TB/s,提升2倍。

关于Vera CPU,NVIDIA采用了代号为Olympus的下一代自研Arm架构,芯片内置88个核心、176条线程(支持NVIDIA Spatial Multi‑Threading),拥有1.8 TB/s的NVLink‑C2C一致性内存互连、1.5 TB系统内存(相当于Grace的3倍)、1.2 TB/s的SOCAMM LPDDR5X内存带宽,并支持机架级机密计算。整体算力、压缩和CI/CD性能均比Grace提升2倍。

NVLink 6交换芯片为Rubin平台提供网络结构,支持400G SerDes、每CPU 3.6 TB/s全互联带宽、总计28.8 TB/s带宽、网络内14.4 TFLOPS的FP8计算,并采用100%液冷设计。

网络方面采用最新的ConnectX‑9和BlueField‑4模块。ConnectX‑9 SuperNIC提供1.6 TB/s带宽,配备200G PAM4 SerDes、可编程RDMA和数据路径加速器,具备顶级安全性,并针对大规模AI进行优化。

BlueField‑4是一款800G DPU,用作SmartNIC和存储处理器。它集成了64核Grace CPU与ConnectX‑9,网络能力比BlueField‑3提升2倍,计算提升6倍,内存带宽提升3倍。

所有这些组件在NVIDIA Vera Rubin NVL72机架中汇聚,与Blackwell相比实现了以下显著提升

- 5倍NVFP4推理(3.6 EFLOPS)

- 3.5倍NVFP4训练(2.5 EFLOPS)

- 2.5倍LPDDR5x容量(54 TB)

- 1.5倍HBM4容量(20.7 TB)

- 2.8倍HBM4带宽(1.6 PB/s)

- 2倍扩展带宽(260 TB/s)

NVIDIA还发布了Spectrum‑X以太网同封装光学解决方案,提供102.4 Tb/s的可扩展交换基础设施、同封装200G硅光子,并在规模化时实现95%的有效带宽。该系统效率提升5倍,可靠性提升10倍,应用运行时长提升5倍。

针对Rubin SuperPOD,NVIDIA推出了Inference Context Memory Storage平台,专为千兆级推理设计,完全集成了NVIDIA的Dynamo、NIXL和DOCA等软件生态。

总结来看,NVIDIA将在其最前沿的DGX SuperPOD中部署Rubin平台,共计8个Vera Rubin NVL72机架。此外,还将推出面向主流数据中心的NVIDIA DGX Rubin NVL8。

凭借这些进步,Rubin平台在推理令牌成本上比Blackwell GB200降低10倍,训练MoE模型所需GPU数量降低4倍。Rubin生态系统得到众多合作伙伴的支持,已进入全面量产阶段,首批芯片将在今年晚些时候交付给客户。

(科技责编:拓荒牛

)

)

晋ICP备17002471号-6

晋ICP备17002471号-6