为了突破AI计算性能的天花板,NVIDIA竟打算把GPU“塞进”高带宽内存(HBM)里!根据韩媒《ETNews》报道,NVIDIA与Meta、三星电子、SK海力士等科技大厂,正研究将GPU核心内置在下一代HBM的技术方案,试图打造更高效、节能的AI芯片架构。

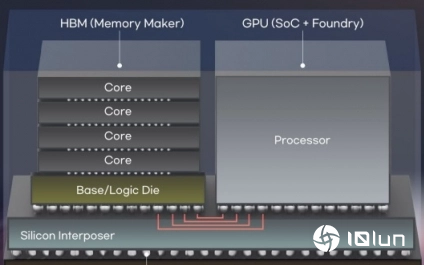

根据报道,这项技术的核心目标,是打破传统处理器与内存分离的限制,让运算与存储能在一个模块中完成,缩短数据传输距离、降低延迟与功耗。具体来说,是把GPU核心直接植入HBM的基底裸晶(Base Die)中,让HBM不再只是内存,而成为具备运算能力的组件。

目前市面上的HBM主要靠堆栈多层DRAM芯片来提升带宽与容量,最底层的基底裸晶主要负责内存与主处理器、其他模块之间的通信。而预计明年量产的HBM4已计划将控制器内置于基底裸晶,这次传出NVIDIA的方案,则是在此基础上更进一步,尝试将部分GPU核心直接集成进去,代表内存模块本身也能进行运算,实现所谓的“存内计算”(In-Memory Computing)。

这样的技术若能实现,不仅能减少数据来回主GPU的传输瓶颈,也可分散运算负载、降低整体功耗,是目前AI芯片设计面临瓶颈下的潜在解决方案。

不过这样的设计也面临不少技术难关。首先,HBM基底裸晶的体积本就有限,能塞入GPU核心的空间极为有限;再者,GPU属于高功耗单元,若直接植入HBM会产生相当热量,如何处理供电与散热,将是这项技术是否能商用化的关键。

NVIDIA与Meta虽然已经与三星、SK海力士展开合作洽谈,但目前仍在研究阶段,距离实际应用还有一段路要走。

(科技责编:拓荒牛

)

)

2025年12月06日 13:05[查看原文]

晋ICP备17002471号-6

晋ICP备17002471号-6