英伟达发布新时代AI数据中心与OCP蓝图,将大幅提高效率降低成本

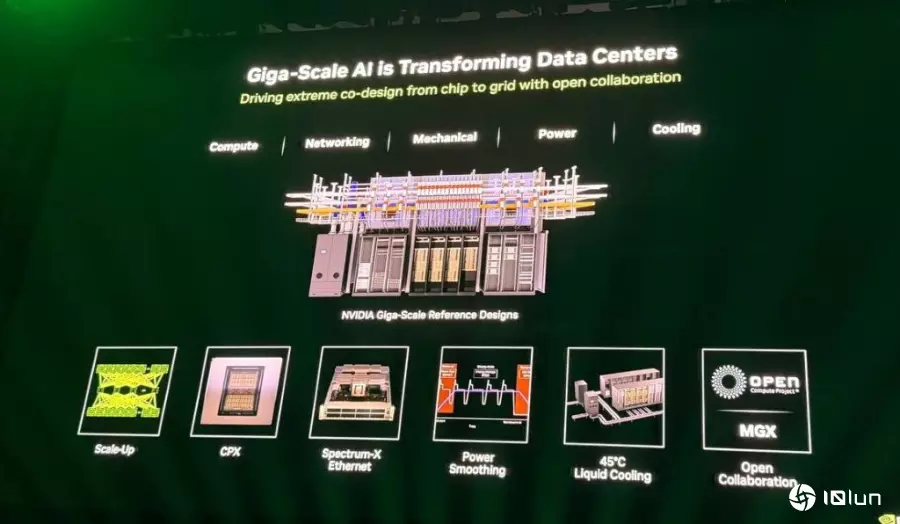

在人工智能(AI)领域进入兆级(gigascale)时代的背景下,全球每天皆听到关于多少GW的AI基础设施正在构建的消息,数据中心也变得日益密集且功能强大。在这其中,英伟达 (NVIDIA ) 正积极推动技术、复杂性、创新与发明,以创建这些被誉为世界上最伟大的工程奇迹的数据中心。这些数据中心不仅能在AI方面取得惊人成就,它们本身更是会升值的资产,随着时间推移变得更智能、更有价值且成本更低。

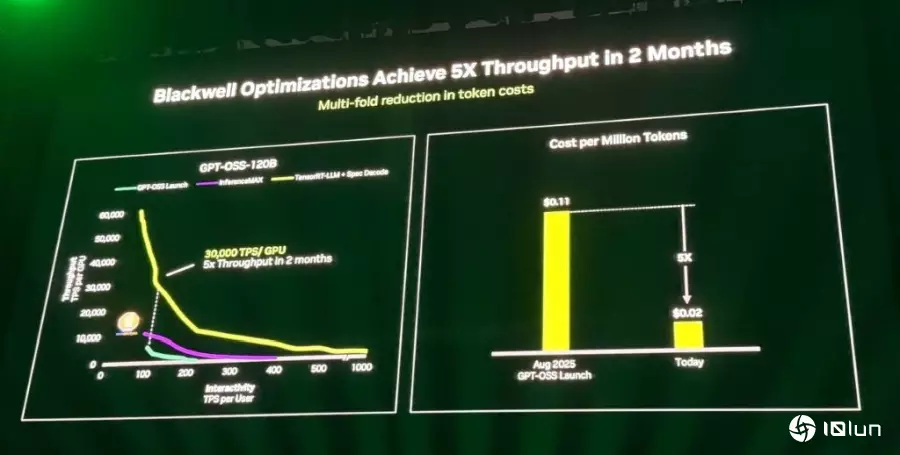

现有架构的突破:GB200成本与性能革命在2025年全球开放运算高峰会上英伟达表示,在现有架构上展现了惊人的性能提升。因为仅在两个月内,英伟达就将B200数据中心对开放源码AI模型GPTO OSS的性能提升了5倍。这一性能上的显著改进,使数据中心提供每百万个token的成本从11美分大幅降至仅2美分。

在实际应用中,这种性能提升直接转化为营收。例如,在Semi Analysis推理最大基准测试中,搭载NVL72的GB200数据中心在处理Deepseek R1模型时,比同等的H200系统高出15倍的性能,这直接影响了数据中心的营收。

另外,所有在OCP中为推进和改进性能所做的努力,包括提高机架的智慧性、更高的密度、更智能高效的电力传输以及Scale Up和Scale Out互联技术,都在建设能大幅降低成本、提高性能的数据中心。这些数据中心甚至会随着时间的前进自行变得更智能,进一步优化这些指标。

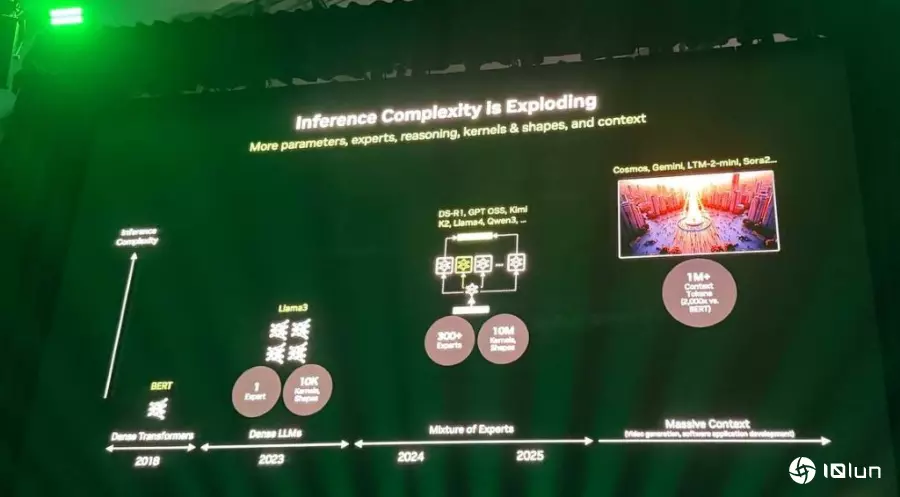

AI模型的复杂性与场景处理的挑战英伟达指出,随着AI推理与模型复杂性呈爆炸式增长,所需的AI核心数量急剧增加。过去处理如Llama 3这类单一密集模型时,可能需要约10,000个不同的AI核心。然而,如今面对HSCR1和GPTO OSS等模型,为了提供高性能,则需要约1,000万个核心。这种复杂性源于模型的规模、大小,以及经常包含数百个专家的混合专家模型。

未来,推理的关键方向之一是“场景”。这指的是模型在提供第一个token或答案之前必须学习或摄取多少资讯。晖达预见,未来的应用可能需要模型摄取约一百万个token后,才能给出第一个答案。而这种高价值应用场景涵盖了电影制作、视频、媒体和内容生成。今天的多媒体内容生成市场约为40亿美元,预计在未来十年内将增长到400亿美元。例如,在编程领域,AI代理可能需要理解数百万行代码,才能添加新功能。

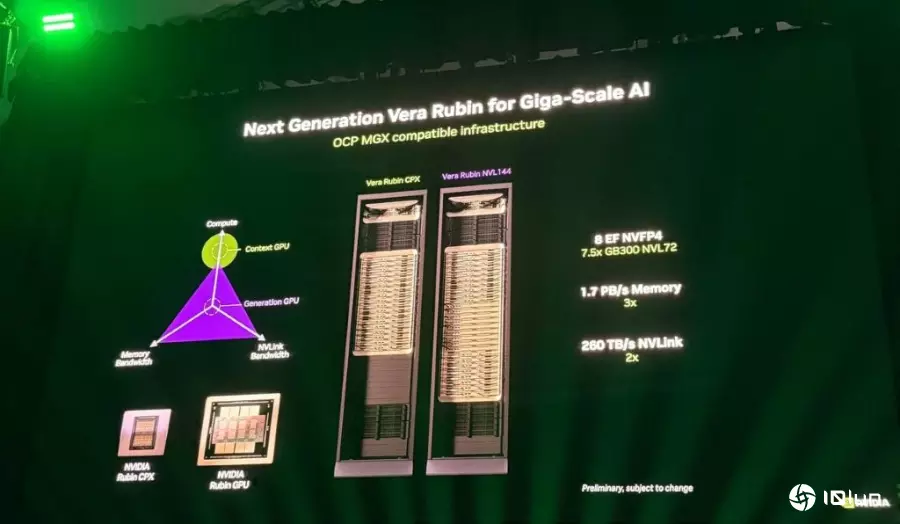

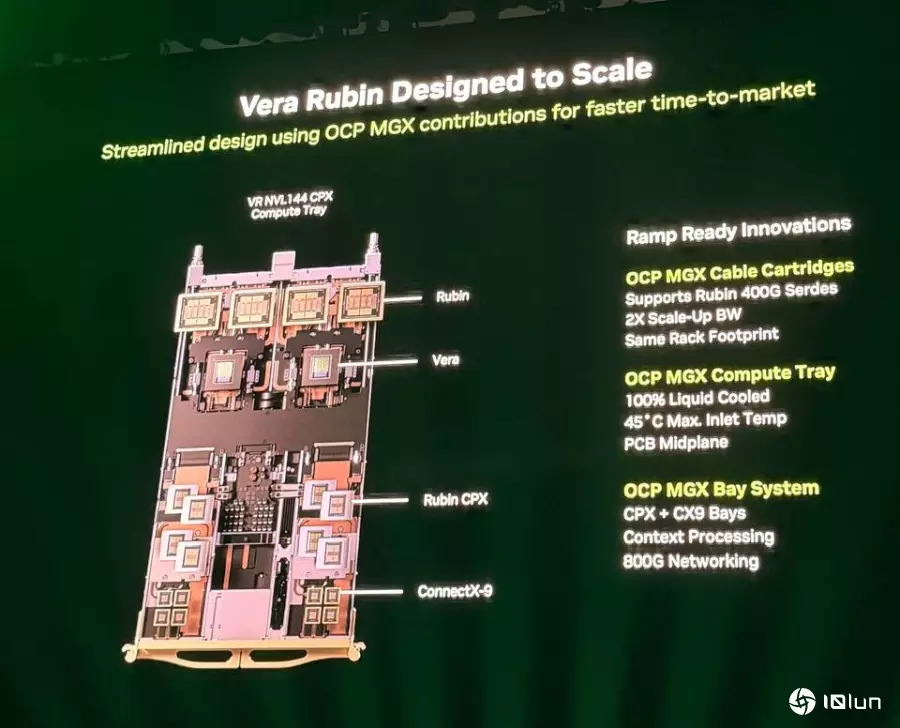

2026年下一代Vera Rubin架构为了解决场景处理的挑战,英伟达宣布下一代架构Vera Rubin将于2026年下半年推出。该架构将部分贡献给OCP社交媒体,并与现有的GB200 OCP基础设施和机架兼容。

英伟达介绍了Vera Rubin架构。首先,在Vera Rubin架构的关键创新在于采用双芯片设计,其中CPX处理器部分,专门用于场景处理,它具备丰富的计算能力,但对IO和内存带宽的需求较低。至于,Ruben GPU部分,则是集成为一个单一的解决方案,使得Vera Rubin提供超过8 exaflops的推理性能,比GB200高出7.5倍以上,并配备更多的内存。在网络方面,将升级至400G Scale Up网络,跨所有GPU提供260 TB/秒的带宽,是GB200的两倍。

另外,Vera Rubin完全兼容英伟达在GB200中定义的OCP NGX基础设施。英伟达正致力于贡献全新的OCP NGX兼容运算托盘,该托盘将完成100%水冷。而该系统也将支持与GB200相同的45度磁性入口温度,这代表着数据中心可以利用现有的水冷基础设施,无需使用更多的冷却器,而且利用相同的电缆压力、OCP机架,并兼容MGX和OCP兼容底座系统。

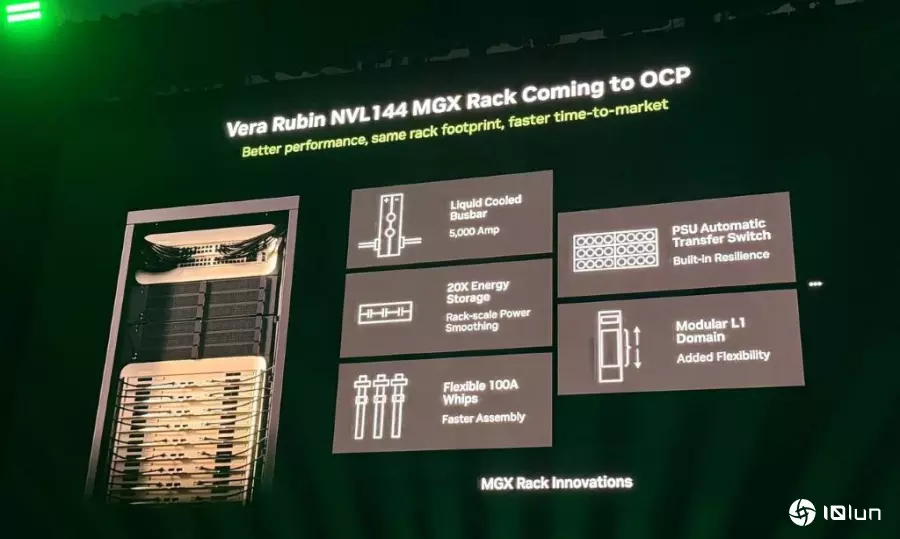

英伟达也展示MGX机架创新设计用于Vera Rubin的内容,包括全新500安培全水冷总线,已提高机架和电力传输的能效,减少热量浪费。还采用灵活的100安培whips新电源传输、SU自动传输开关来提高弹性,也就是当一个机架故障时,另一个可以接替。最后是模块化L1领域,达到更好的可维护性和可配置性。而为完成异构计算的紧密耦合,英伟达还推出NVLink Fusion。这是一种IP和小芯片技术,允许其他CPU和加速器参与NVLink和OCP设计基础设施。

英伟达宣布多项合作伙伴关系- 富士通(Fujitsu)旗下Monaka处理器将使用NVLink Fusion协议与英伟达的GPU进行紧密耦合。

- 英特尔(Intel)将制造Fusion兼容CPU,以便在数据中心环境中连接到英伟达GPU。

- 英伟达正在将三星(Samsung)加入到现有的Alchip、Alstera和RL MediaTek名单中,协助社交媒体将他们的加速器与英伟达CPU或NVLink集成。

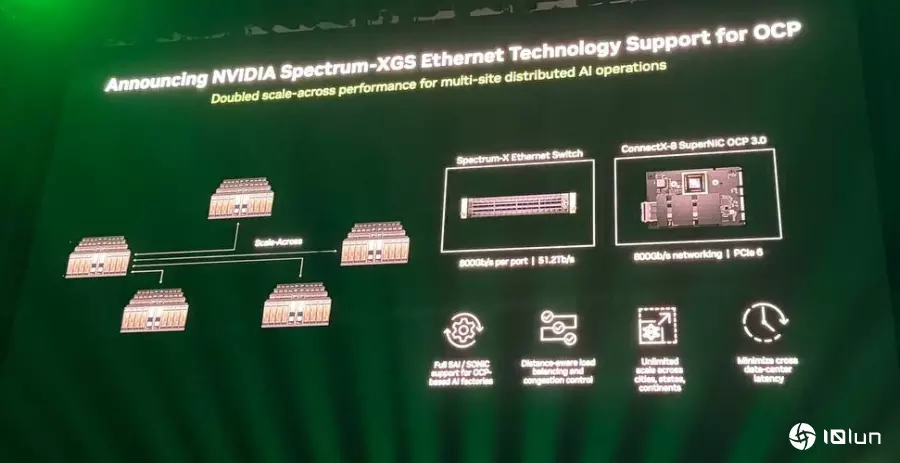

英伟达强调,将数十万乃至百万级GPU连接到一起是一项艰巨的任务,这需要以太网标准的支持,这使得英伟达对Spectrum在AI数据中心世界的进展和采用感到兴奋。目前,Meta已宣布向OCP贡献采用Spectrum XP和Facebook开源交换系统(FBOSS)的Miniack 3N交换机。而微软旗下的Fairwater数据中心是世界上最大、最快的AI超级计算机之一,采用开放标准以太网构建,其数十万GPU的背板互联是以Spectrum X和OCP SONiC操作系统为主。

至于,甲骨文(Oracle)及OpenAI共同规划的星际之门 (Stargate) 数据中心是世界上最大的AI超级计算机基础设施之一,其第一个数据入口就是采用Spectrum和OCP技术构建,完成了95%的有效带宽和零应用延迟。其他采用英伟达Spectrum XGX技术的数据中心,在采用OCP软件和标准下,允许多站点进行连接,跨越不同地理区域,甚至整个大陆进行百万级GPU规模的训练。

预期2027年Kyber与800V DC基础设施在2027年下半年,英伟达将推出Kyber设计。Kyber的目标是将500个GPU连接到单一机架中。为完成这种规模和能耗密度,英伟达正与业界合作,推动800V伏特DC直流电基础设施,这是Mount Diablo努力的一部分。许多合作伙伴已经开始规划围绕800V DC的数据中心。

英伟达进一步指出,这种基础设施是与OCP社交媒体共同创建的。这是一种能提供惊人AI能力,并且能在未来数年内持续增长和扩展的数据中心。英伟达已设置MGX生态系统墙,展示构建世界上最强大AI系统的各种组件。

(首图来源:科技新报摄)

(科技责编:拓荒牛

)

)

晋ICP备17002471号-6

晋ICP备17002471号-6