MIT新突破:视觉深度学习让软体机器人自适应控制更精准

近期,麻省理工学院(MIT)的一支科研团队在机器人技术领域取得了突破性进展,他们开发出一种依赖视觉的深度学习新方法,仅需单个摄像头,即可赋能软体机器人与仿生机器人自我学习与控制运动的能力。

这项创新技术有望大幅度削减机器人研发成本,相关研究成果已在自然期刊上于6月25日正式发表。据介绍,尽管当前工业机器人在建模与控制方面相对简便,但其刚性结构限制了它们在复杂地形,如狭窄或凹凸不平区域的应用潜力。软体机器人与仿生机器人虽然在适应多变环境方面展现出显著优势,但它们往往需要大量传感器和精密设计的空间模型,这无疑增加了研发难度与成本。

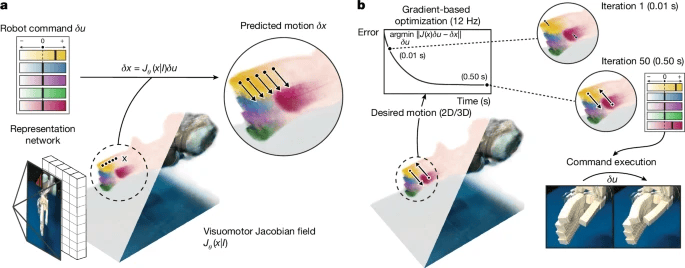

MIT的研究团队通过深度学习技术攻克了这一难题。新系统利用单个摄像头捕捉机器人运动画面,并结合“神经雅可比场(NJF)”技术,使机器人能借助视觉反馈对自身形态与运动能力形成认知。研究团队使用多视角、时长2至3小时的随机运动视频对多种机器人进行训练,成功训练出能从单帧图像中重建机器人三维形态及其动作范围的神经网络。

在多项测试中,该系统在气动软体机械手、16自由度的奥利格罗机械手、3D打印机械臂以及低成本的Poppy机械臂上均表现优异。具体而言,关节运动误差低于3度,指尖控制误差小于4毫米,且能根据环境变化进行自我调整。项目负责人、MIT助理教授文森特·西茨曼指出,将视觉作为弹性传感手段,为农业、建筑等非结构化环境中的机器人应用开辟了新路径。

西茨曼教授进一步解释,这种视觉反馈机制能够构建机器人自身运动的动力学模型,即便在传统定位方式难以奏效的场景下,也能实现自监督运行。这意味着,未来的软体机器人与仿生机器人将更加智能,能够更好地适应各种复杂环境,执行多样化任务。

(科技责编:拓荒牛

)

)

2025年07月14日 14:02[查看原文]

晋ICP备17002471号-6

晋ICP备17002471号-6