AI芯片是时下各个巨头极力追赶的产品。

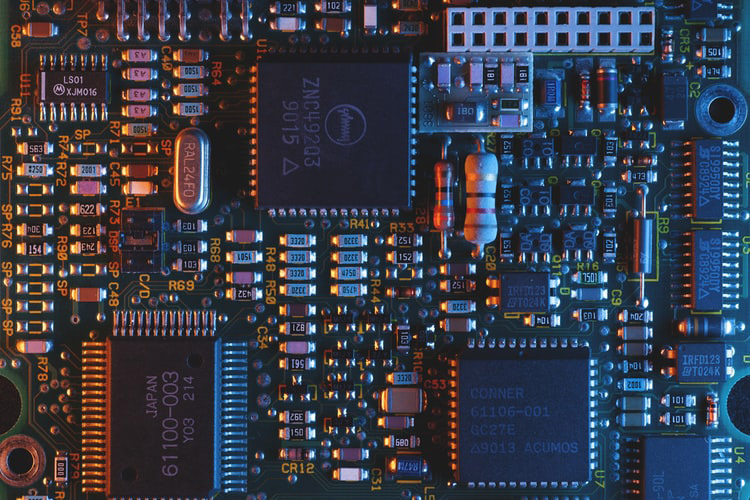

世间事分为可以计算和不可以计算,例如你给你女朋友买的礼物是可以计算的,但是您对你女朋友的爱是不可以计算的。类似在科技网络领域更狠的事是,即使不可以计算也需要算力来告诉不可以计算,所以现在几乎所有工作的背后都会涉及到算力:AI芯片。所以对于对科技网络感兴趣的人懂不懂芯片,芯片都无时无刻的存在着,并支撑着我们的PC、手机、汽车、轮船、交通、工业制造等等生活工作的方方面面。

且随着深度学习(DNN)算法需要海量数据的训练,而传统计算架构无法支撑深度学习算法的大规模计算需求,因此AI技术的发展对计算芯片提出了新的需求,

本篇重点讲述何为AI芯片,AI芯片的分类,不同AI芯片的对比,AI芯片的主流技术路线,AI芯片产业概况,国外国内AI芯片和企业发展情况,最后小结AI芯片发展的预期。

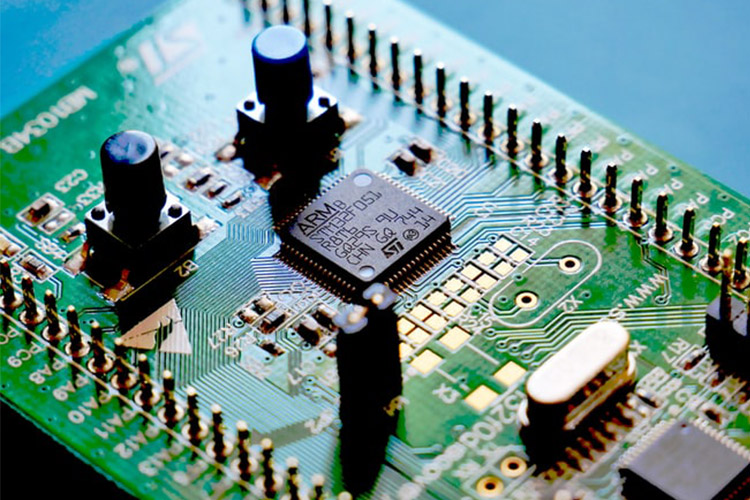

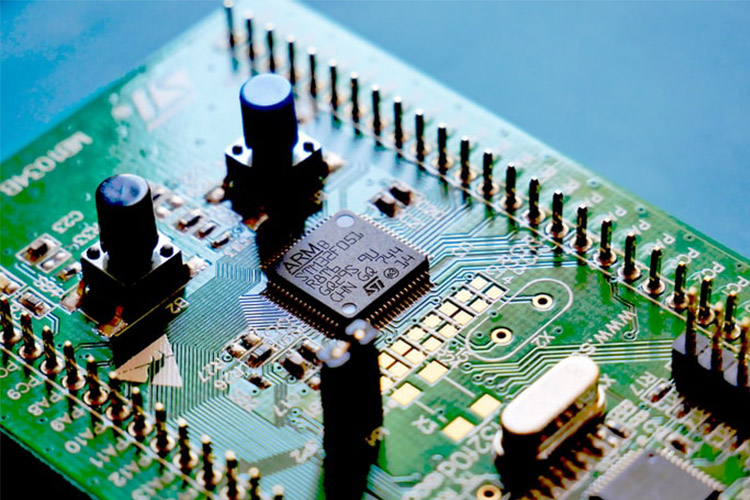

什么是AI芯片

以下3种情况都属于AI芯片:

第一种是能处理AI通用任务且具有核心知识产权(IP)的处理器;

第二种是融合运营AI算法的普通处理器;

第三种是较高效提升了语音、图像一项或者多项效率和迭代能力的处理器。

AI芯片分为两类:

AI芯片按使用场景分为云端、终端两类:

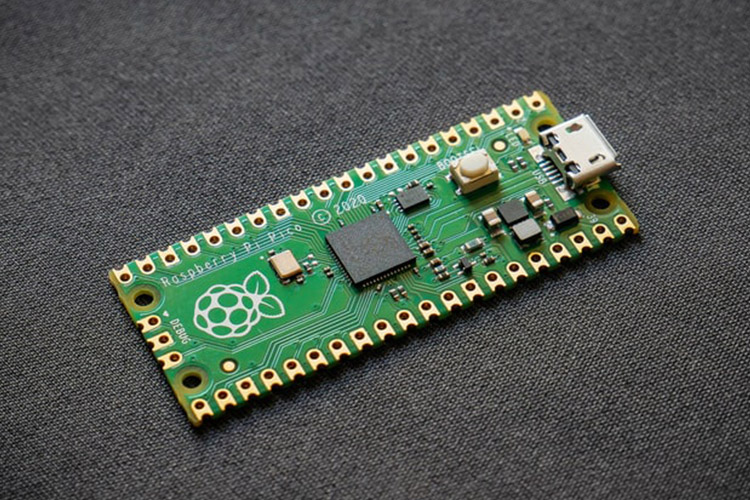

云端有CPU、GPU、FPGA,终端有ASIC、DSP。其中云端主要以训练为主,终端以推理任务为主。

不同架构的芯片在通用/专用性、性能、功耗方面有各自的优点和缺点。CPU 通用性最强,但时延严重、散热高、效率最低;GPU 相比其他芯片,通用性稍强、速度快、效率高,但是在神经网络的执行阶段效率低;DSP 速度快、能耗低,但是任务单一,目前成熟商品仅作为处理器 IP 核使用;FPGA 具有低能耗、高性能以及可编程等特性,相对于 CPU 与 GPU 有明显的性能与能耗优势;ASIC 可以更有针对性地进行硬件层次的优化,从而获得更好的性能。

当然,ASIC 芯片的设计和制造需要大量的资金、较长的时间周期和工程周期,而且深度学习算法也在快速迭代,ASIC 类芯片一旦定制无法再次进行写操作,FPGA 具有硬件可升级、可迭代的优势。所以当前阶段,GPU 配合 CPU 将是人工智能芯片的主流,而后随着视觉、语音、深度学习的算法在 FPGA 上的不断优化,之后会固化到 ASIC 上以降低成本。

时下AI芯片的2条技术路线

像处理器(GPU)到数字信号处理器(DSP),再到半定制电路(FPGA)和全定制电路(ASIC),这 5 种类型的芯片通用性依次递减,为升级方向;

另一条路径是遵循非冯诺依曼计算架构,以类脑芯片为代表,采用人脑神经元的结构来提升计算能力,但是从落地情况来看,若实现真正产业化还需要搭建生态系统,包括建立起一整套编程环境、编译器等工具。

技术路线的趋势是,从通用到专用,然后再由专用到另一个域的通用。

AI芯片的产业分析

从产业的角度来看,不同技术路线的企业有不同的特点。

AI芯片的国外国内情况比对

国际科技网络巨头公司谷歌、脸书,亚马逊等等在AI芯片领域从云端训练到终端产品应用,在开源框架赋能产业行业上有一定的领先优势。但是国内的AI芯片在业务场景上有后发优势。例如:阿里巴巴根据业务场景定制化AI芯片的平头哥半导体公司,及其刚刚从脸书挖掘的AI框架人才贾杨青等来看国内的企业也在打造从AI芯片注重云端训练+AI芯片终端响应+AI算法框架开源的生态体系。

AI发展预期

未来面对垂直细分领域的 AI 芯片市场前景广阔。随着人工智能应用场景的细分市场越来越多,专门为某些应用场景定制的芯片性能优于通用芯片,终端芯片呈现碎片化、多样化的特点,并且目前尚未形成市场垄断,机会较多。

一个既知的事实是摩尔定律已经接近物理的极限,而AI的任务之一是深度学习,深度学习对数据的读写操作很多时候是高于计算功耗。所以未来是一方面提升AI芯片的架构性能,另外一方面提升芯片的存取单元,例如:未来需要更好的容器架构师。

AI内核有数据+算法+算力三个部分构成,本篇讲的就是内核之一的AI芯片。

(科技产业责编:陈峰

)

)

晋ICP备17002471号-6

晋ICP备17002471号-6